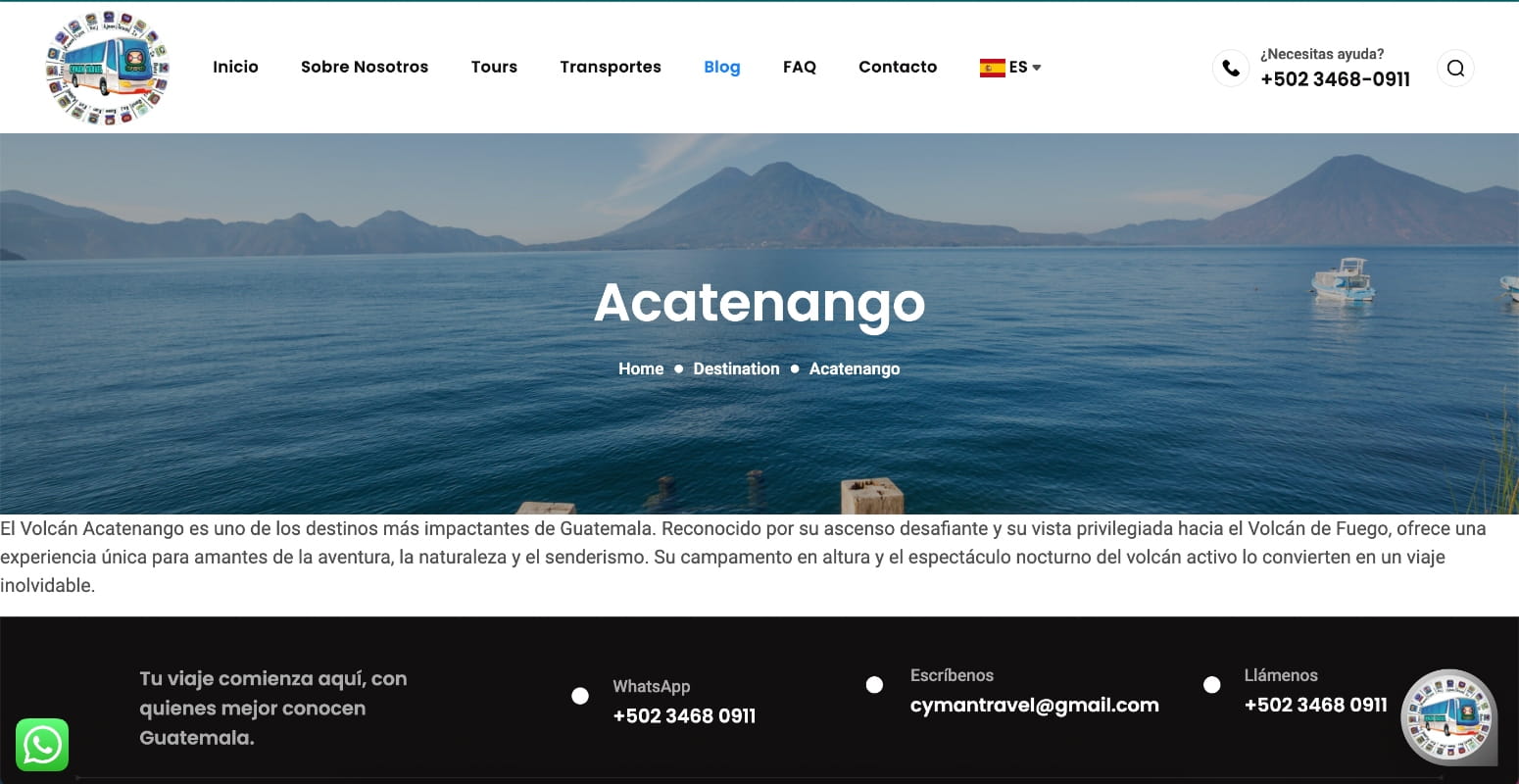

Si tienes un sitio web, buscas el nombre de tu marca y no ves ningún resultado en Google, es muy probable que el motor de búsqueda no haya rastreado y/o indexado tu sitio correctamente. También puede ocurrir que el sitio esté indexado, pero no aparezca en la primera página de resultados debido a la falta de una estrategia SEO adecuada. Comprender cómo Google rastrea, indexa y posiciona un sitio web es clave para detectar el origen del problema y aplicar las acciones correctivas necesarias.

¿A qué nos referimos con “rastreo”?

El rastreo es el primer paso que realizan los motores de búsqueda. En esta etapa, Google detecta un sitio web y comienza a navegar por sus diferentes URLs mediante bots (Googlebot), con el objetivo de comprender su temática, industria, estructura y el contenido que ofrece a los usuarios.

Si el rastreo se ve impedido total o parcialmente, Google no podrá acceder al contenido del sitio, lo que afecta directamente su indexación y visibilidad.

¿Qué quiere decir que tu sitio web fue “indexado”?

Una vez que los motores de búsqueda rastrean un sitio web, proceden a registrar las URLs detectadas en su índice, un gran repositorio de páginas web. Este proceso se denomina indexación. Cuando una URL se encuentra dentro del índice de Google, significa que puede mostrarse como resultado cuando un usuario realiza una búsqueda relevante.

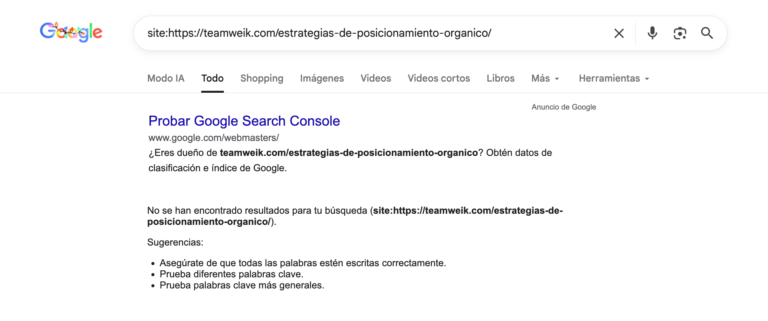

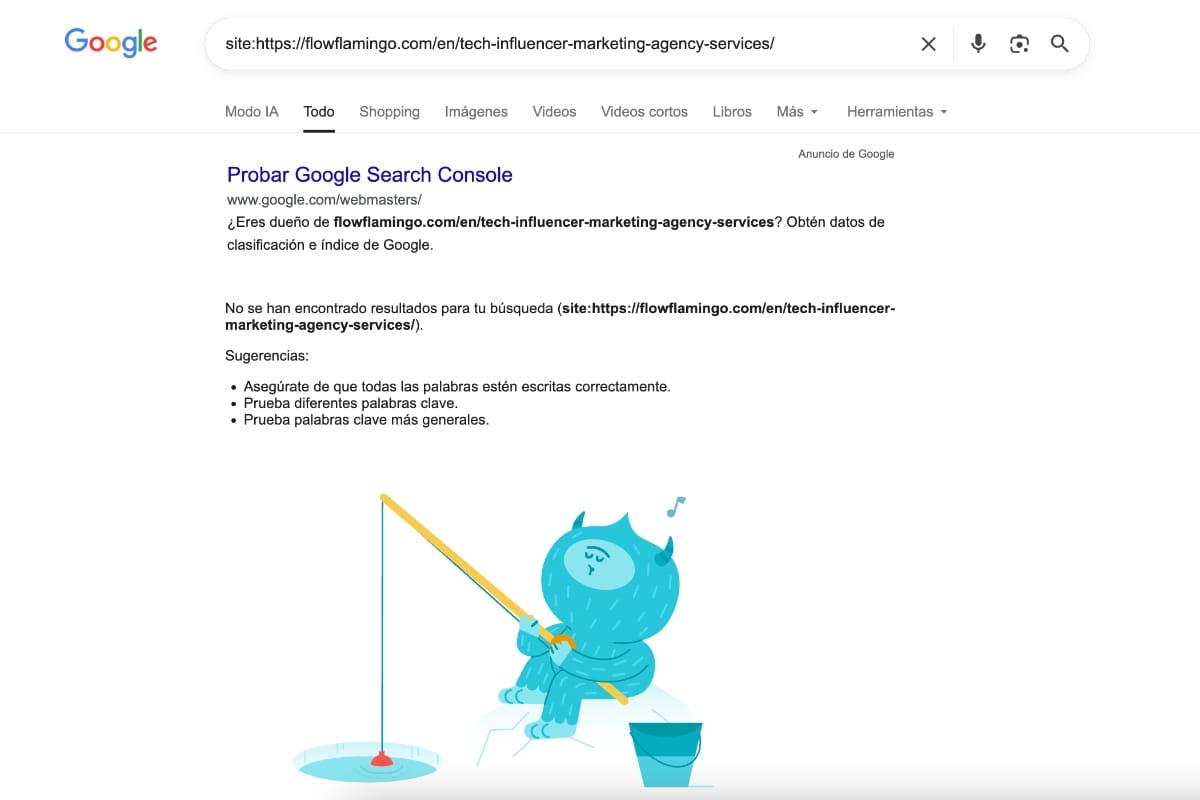

Para corroborar si una URL específica o todo tu sitio web se encuentra indexado, puedes utilizar el comando site: seguido del dominio en el buscador de Google. De esta manera, podrás identificar qué páginas están actualmente en el índice.

Si el resultado indica que una URL no se encuentra indexada, puede deberse a diversos factores que detallamos a continuación.

Razones por las que Google no indexa un sitio web

Existen múltiples motivos técnicos y de contenido que pueden impedir la indexación de un sitio web. A continuación, detallamos los más frecuentes y su impacto en la visibilidad orgánica:

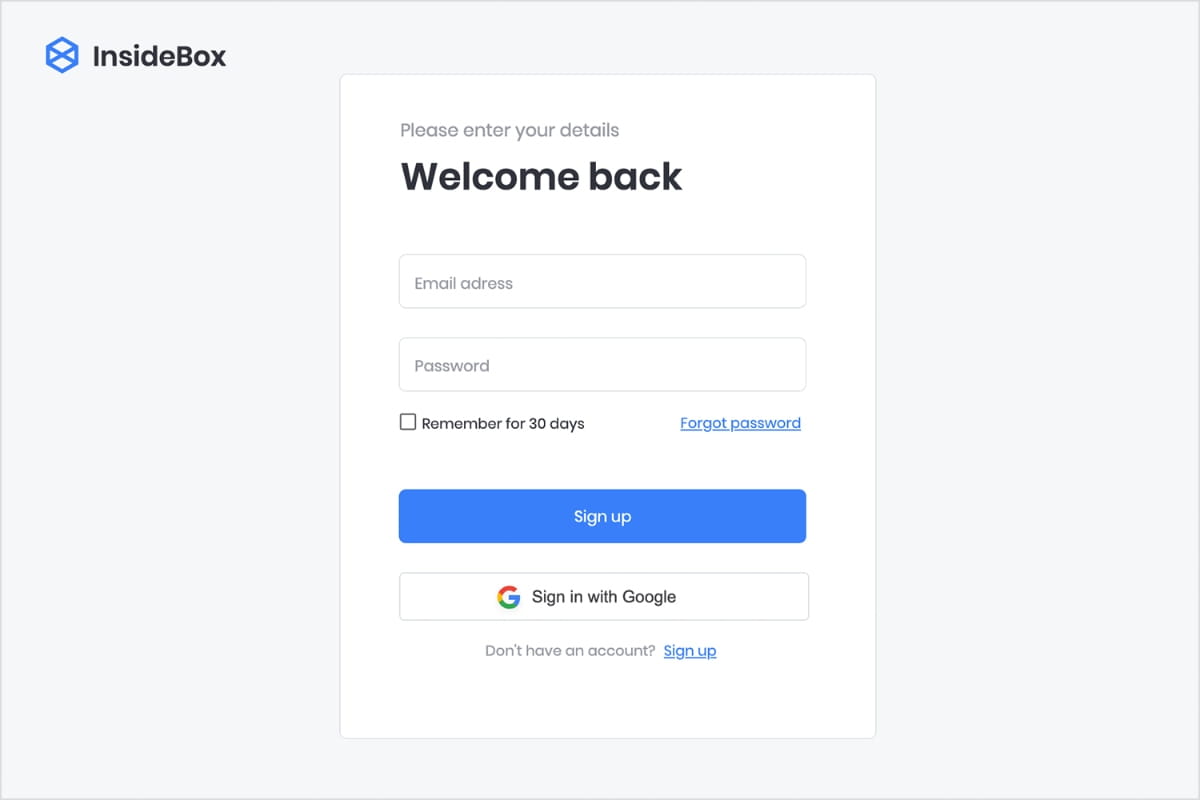

1 – Se impide el acceso a los motores de búsqueda mediante un proceso de login

Cuando un sitio web o parte de su contenido requiere autenticación para ser visualizado, los motores de búsqueda no pueden acceder a él. Googlebot no inicia sesión ni completa formularios, por lo que cualquier contenido protegido por credenciales queda fuera del alcance del rastreo.

Este escenario es común en entornos de staging, áreas privadas o sitios mal configurados en producción. Si las páginas importantes requieren login, Google no podrá rastrearlas ni indexarlas, afectando directamente la visibilidad del sitio en los resultados de búsqueda.

2 – Se bloquea el contenido a través de pop ups o intersticiales que dificultan el rastreo

El uso excesivo de pop ups, banners invasivos o intersticiales que cubren el contenido principal puede interferir con el rastreo y la interpretación de la página por parte de Google. En algunos casos, estos elementos se cargan antes que el contenido o impiden su correcta visualización, lo que dificulta que Googlebot acceda al texto relevante. Además, Google penaliza las experiencias intrusivas, lo que puede impactar negativamente tanto en la indexación como en el posicionamiento del sitio.

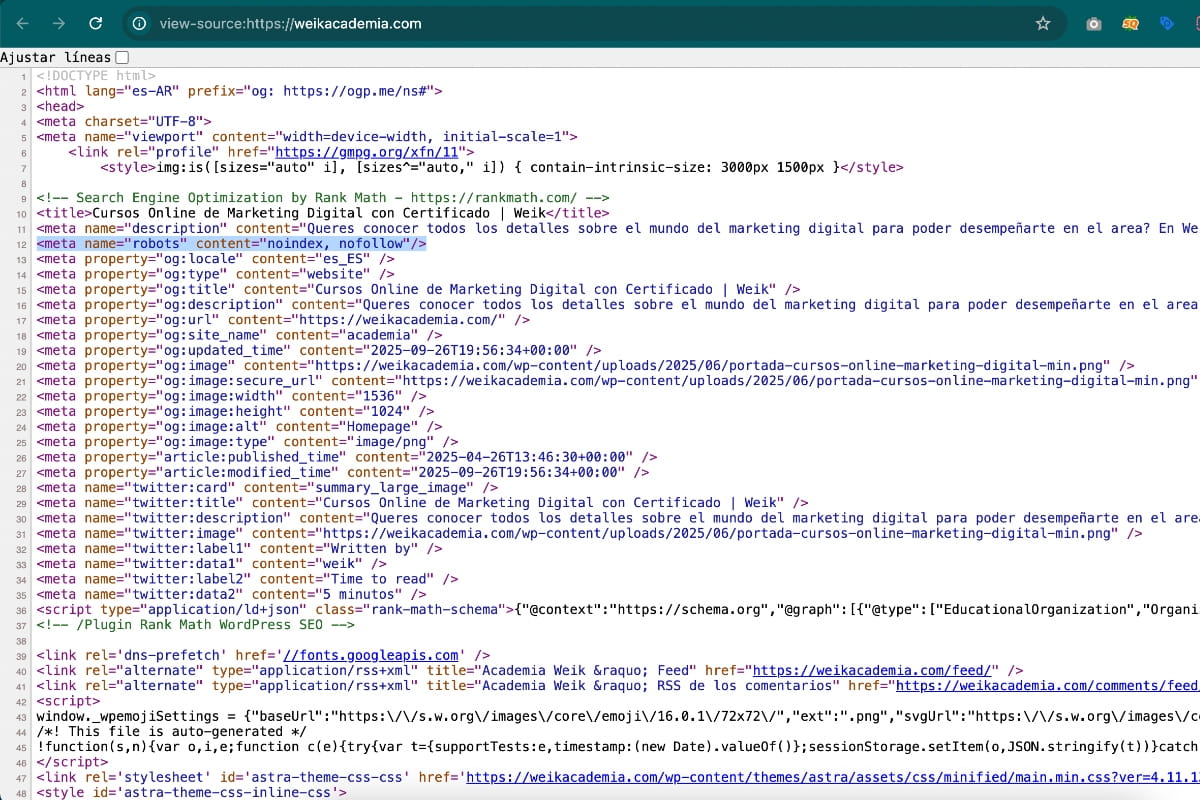

3 – Las URLs cuentan con una etiqueta meta robots con la directiva noindex

La etiqueta meta robots con el valor noindex indica explícitamente a los motores de búsqueda que una página no debe ser indexada. Esta directiva suele utilizarse de forma intencional en páginas de bajo valor, resultados internos o entornos de prueba.

Sin embargo, una mala implementación puede provocar que páginas estratégicas queden fuera del índice de Google. Revisar estas etiquetas es fundamental, especialmente durante migraciones, rediseños o cambios en la arquitectura del sitio.

4 – La etiqueta canonical implementada apunta a una URL diferente a sí misma

La etiqueta canonical le indica a Google cuál es la versión preferida de una página cuando existen URLs similares o duplicadas. Si una página tiene una canonical que apunta a otra URL, Google puede decidir no indexarla y priorizar la URL declarada como canónica. Una mala configuración de canonicals puede provocar la desindexación involuntaria de páginas importantes, consolidando señales en URLs incorrectas y afectando la cobertura del índice.

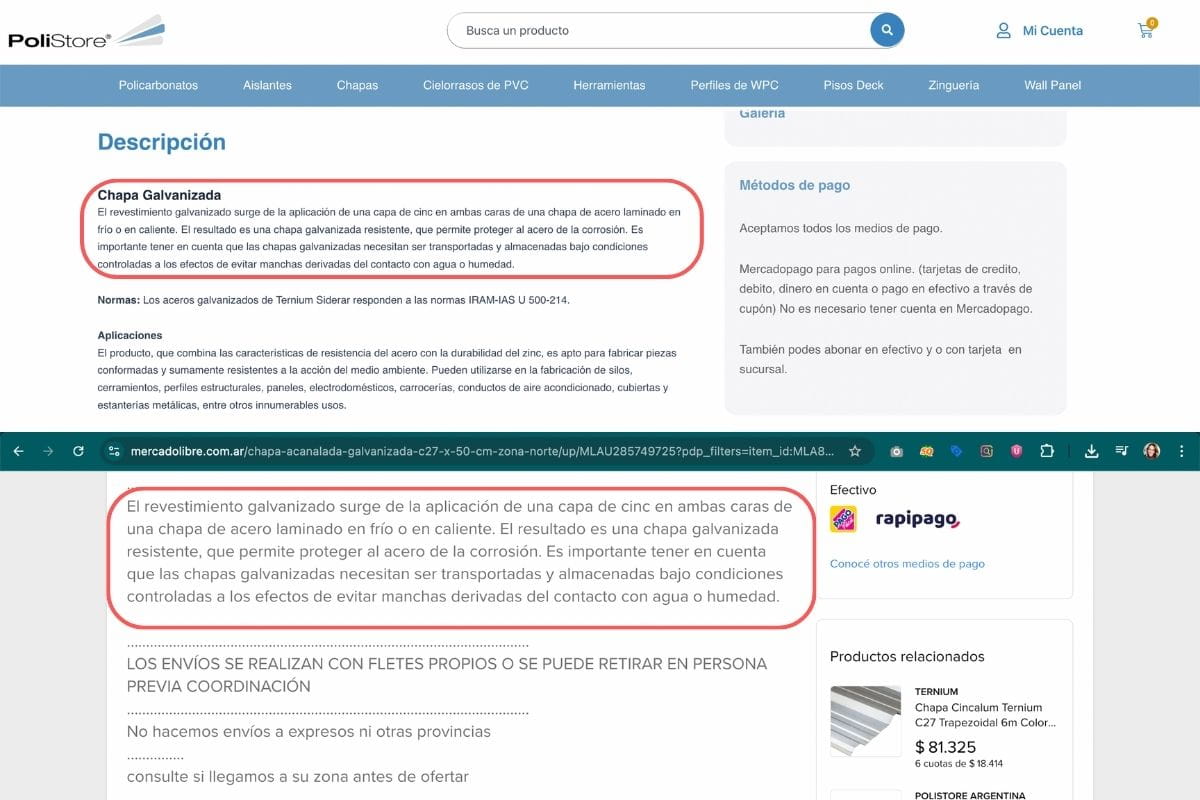

5 – El contenido del sitio es duplicado o de bajo valor

Cuando Google detecta contenido duplicado interno o externo, puede optar por no indexar todas las versiones disponibles y mostrar solo una de ellas (y siempre termina siendo la URL con mayor vigencia en Internet).

Además, el contenido de bajo valor, escaso o poco relevante puede ser considerado insuficiente para formar parte del índice. Google prioriza páginas que aporten información original, útil y diferenciadora, por lo que la calidad del contenido es un factor determinante en el proceso de indexación.

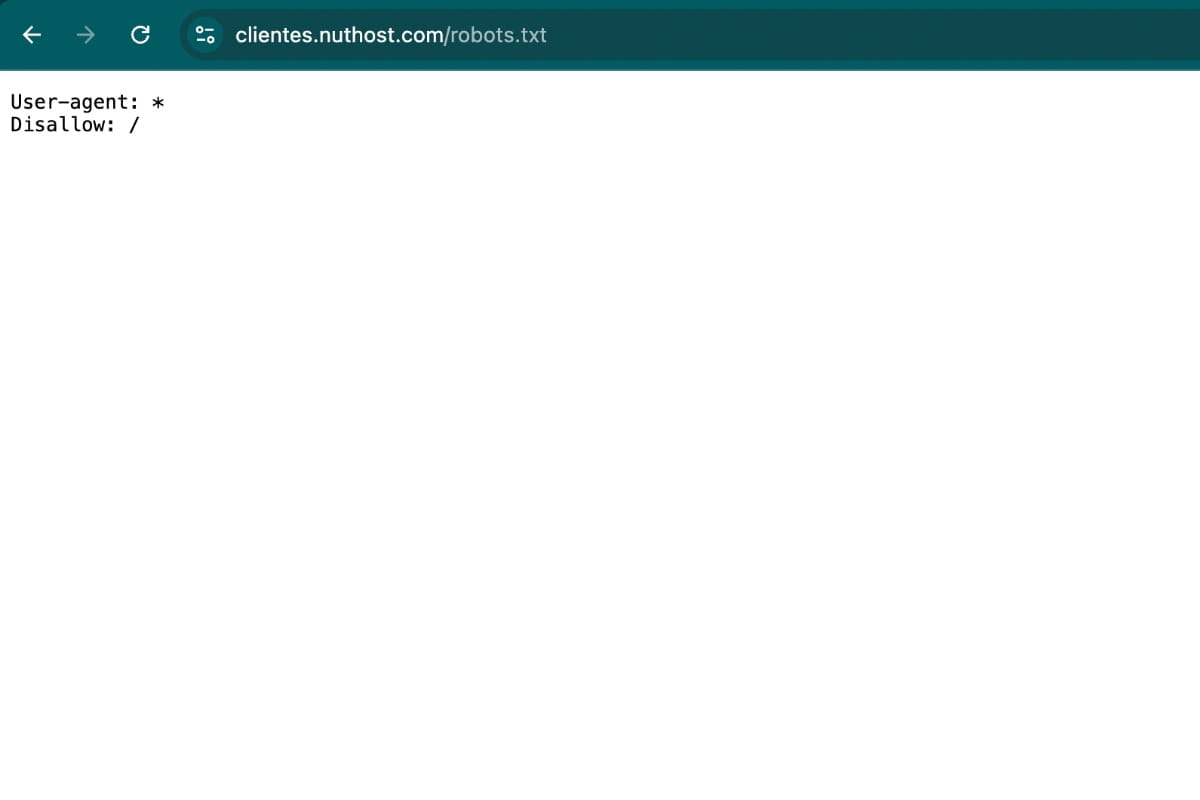

6 – Se bloquea el rastreo mediante el archivo robots.txt

El archivo robots.txt permite indicar a los motores de búsqueda qué secciones del sitio pueden o no rastrear. Un error en su configuración puede bloquear accidentalmente directorios completos o incluso el sitio entero. Si Googlebot no puede rastrear una URL debido a una regla en robots.txt, no podrá acceder a su contenido ni indexarlo correctamente. Es fundamental auditar este archivo para evitar bloqueos involuntarios.

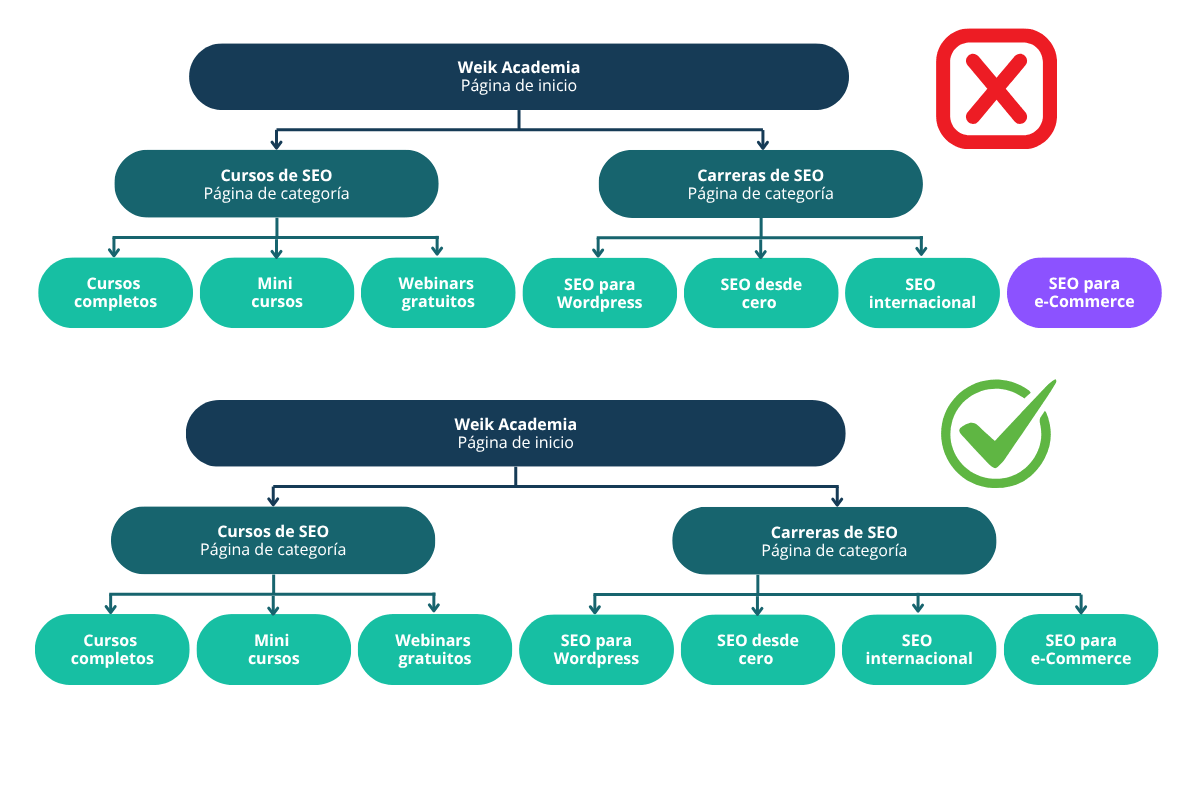

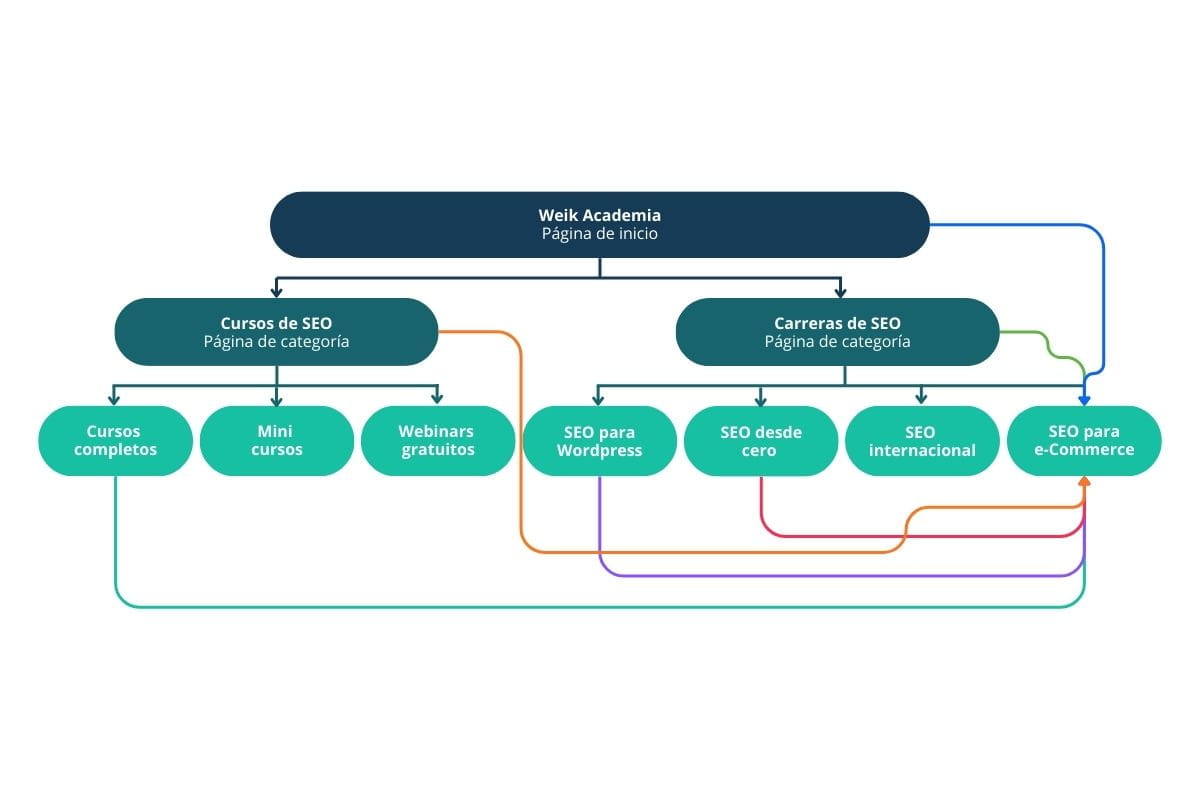

7 – Existe una escasez de enlazado interno que dificulta la navegación de los bots

El enlazado interno es clave para que Google descubra y comprenda la estructura de un sitio web. Si una página no recibe enlaces internos desde otras URLs, puede quedar aislada, dificultando su rastreo e indexación. Una arquitectura pobre o mal conectada limita la capacidad de Google para distribuir autoridad y descubrir nuevo contenido, afectando negativamente la cobertura del índice.

¿Qué acciones adicionales puedo realizar?

Si tu sitio presenta problemas de rastreo o indexación, puedes aplicar las siguientes acciones para mejorar su visibilidad:

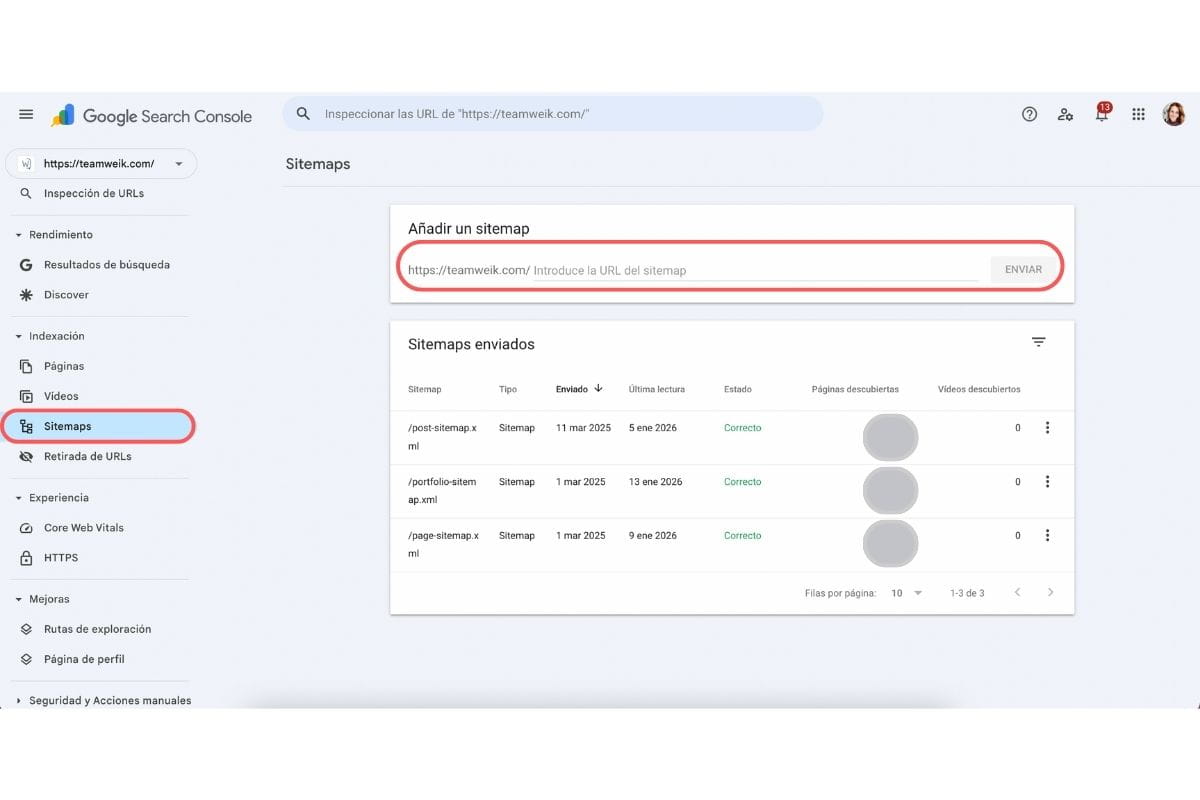

– Declarar un archivo Sitemap XML y enviarlo a Google Search Console

El sitemap XML actúa como un mapa del sitio para los motores de búsqueda, facilitando la detección de URLs relevantes. Declararlo y enviarlo a través de Google Search Console permite acelerar el descubrimiento de nuevas páginas, identificar errores de indexación y comprender cómo Google interpreta la estructura del sitio. Aunque no garantiza la indexación, es una herramienta clave para mejorar la cobertura y el control del rastreo.

– Implementar una estrategia sólida de enlazado interno

Una correcta estrategia de enlazado interno ayuda a distribuir autoridad entre las páginas del sitio y a guiar tanto a usuarios como a motores de búsqueda. Al enlazar contenidos relacionados de forma lógica y jerárquica, se facilita el rastreo, se mejora la experiencia de navegación y se refuerza la relevancia temática. Además, el enlazado interno permite destacar páginas estratégicas y aumentar sus probabilidades de indexación y posicionamiento.

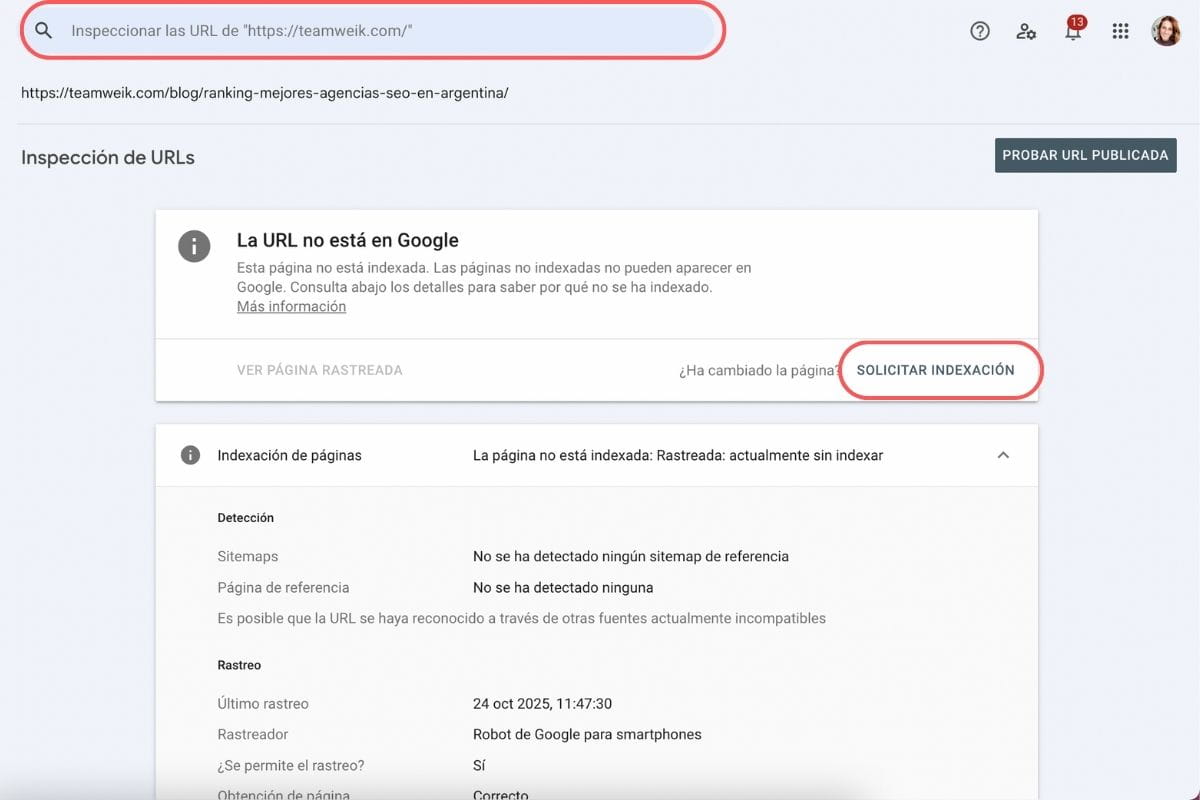

– Solicitar la indexación manual de URLs desde Google Search Console

Google Search Console permite solicitar manualmente la indexación de una URL específica mediante la herramienta de inspección. Esta acción es especialmente útil al publicar contenido nuevo, actualizar páginas importantes o corregir errores técnicos. Si bien no asegura una indexación inmediata, ayuda a acelerar el proceso y a alertar a Google sobre cambios relevantes dentro del sitio.

– Crear un sitemap HTML e implementarlo en el footer del sitio

El sitemap HTML es una página visible para los usuarios que contiene enlaces a las principales secciones del sitio. Además de mejorar la experiencia de navegación, refuerza el enlazado interno y facilita el descubrimiento de URLs por parte de los motores de búsqueda. Ubicarlo en el footer asegura que esté accesible desde cualquier página, aportando valor tanto a usuarios como a bots.

Mi web se encuentra indexada pero no aparece en los primeros resultados, ¿qué puedo hacer?

Cuando un sitio está indexado pero no logra posicionarse en los primeros resultados, el foco debe estar en la optimización SEO y la autoridad del dominio:

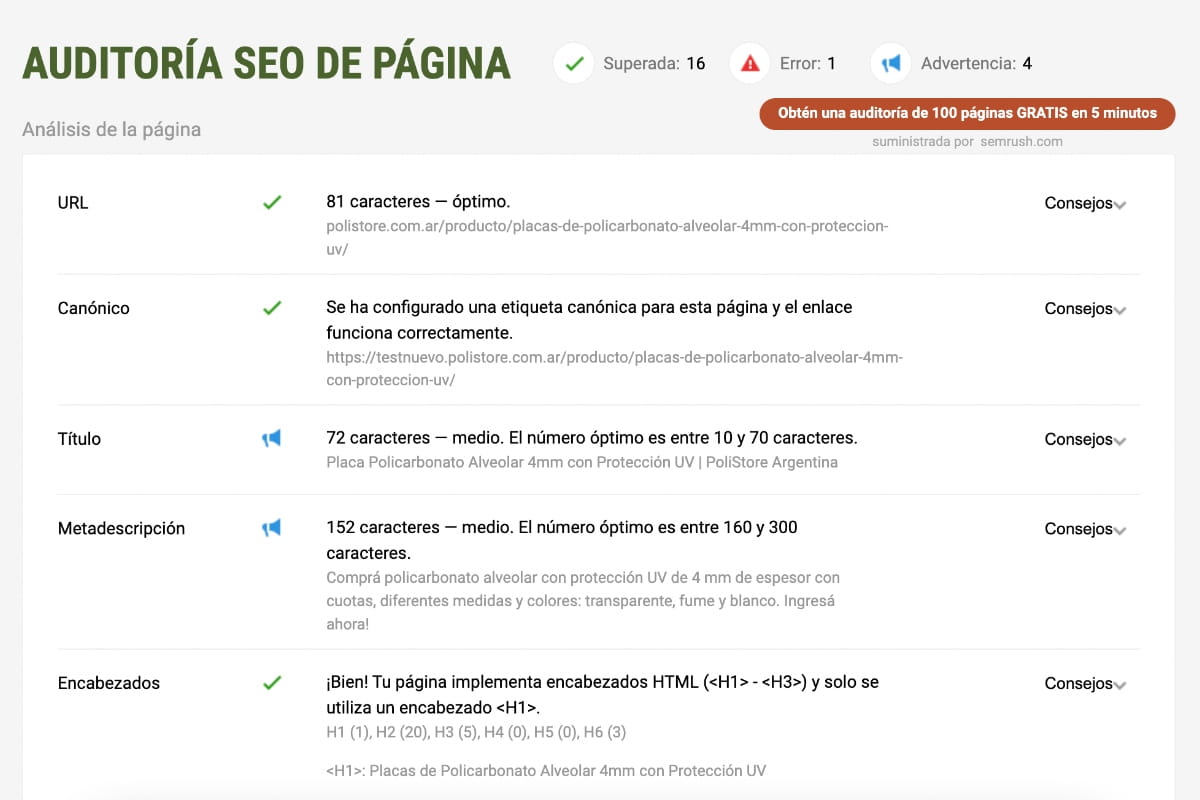

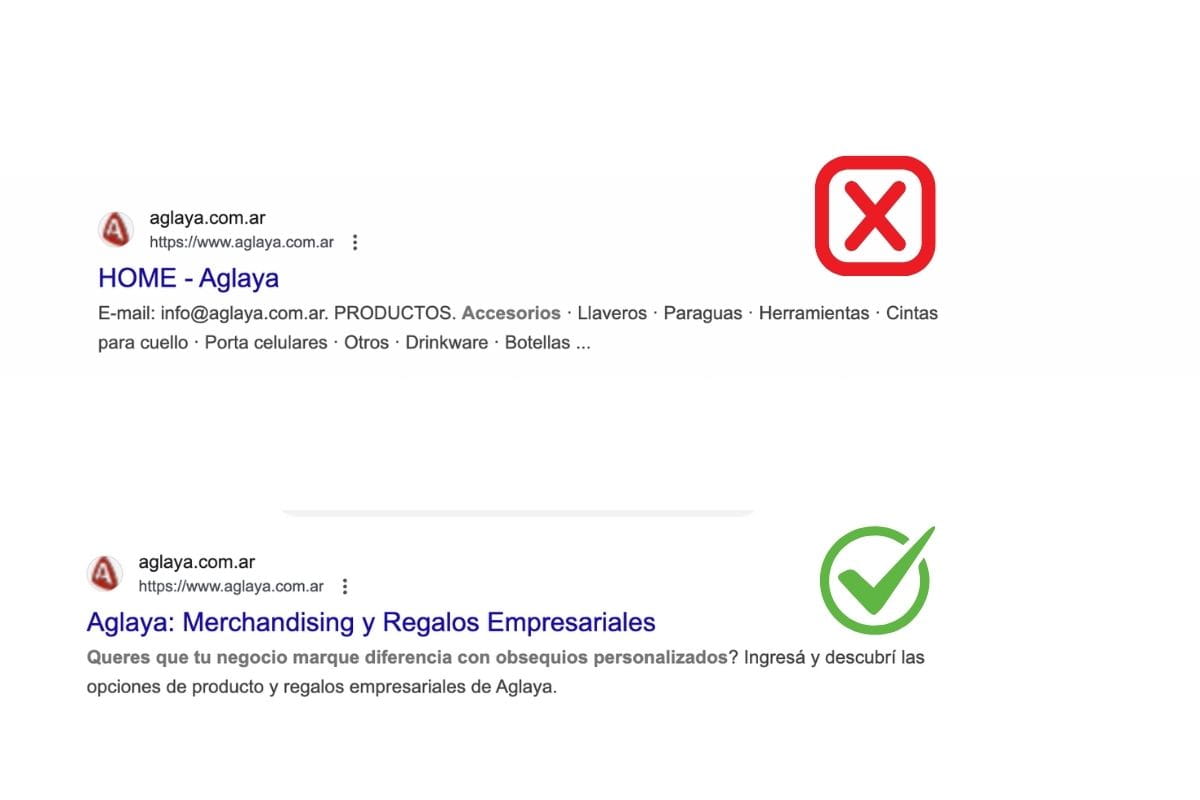

1 – Mejorar las etiquetas SEO y la calidad del contenido

Las etiquetas SEO, como el title, la meta description y los encabezados, ayudan a Google a comprender el contenido y la relevancia de una página. Una mala optimización o la falta de alineación con la intención de búsqueda puede limitar el posicionamiento. Además, el contenido debe ser profundo, actualizado y orientado a resolver las necesidades del usuario. Mejorar la calidad y la optimización semántica es clave para competir en los primeros resultados.

2 – Implementar datos estructurados según el tipo de página

Los datos estructurados permiten proporcionar información adicional a los motores de búsqueda sobre el contenido de una página. Su correcta implementación puede mejorar la comprensión del sitio y habilitar rich results en las SERPs, aumentando la visibilidad y el CTR. Aunque no son un factor de ranking directo, contribuyen a una mejor interpretación del contenido y a una presentación más atractiva en los resultados.

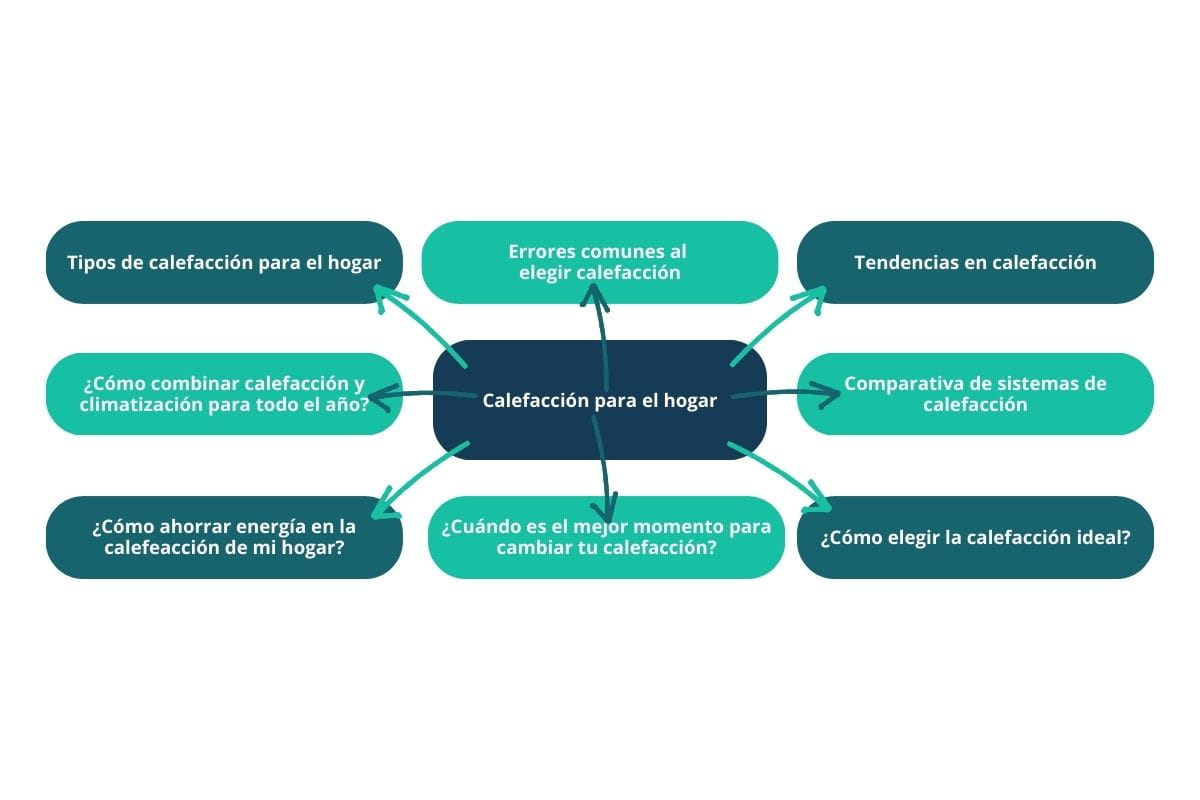

3 – Generar un cluster de contenido que refuerce la autoridad temática

Los clusters de contenido se basan en la creación de una página pilar y múltiples contenidos relacionados que la enlazan internamente. Esta estrategia ayuda a consolidar autoridad sobre un tema específico, mejora la relevancia semántica y facilita el rastreo. Google valora los sitios que demuestran profundidad y coherencia temática, lo que aumenta las posibilidades de posicionar en consultas competitivas.

4 – Impulsar una estrategia de backlinks de calidad

Los enlaces externos siguen siendo uno de los factores de posicionamiento más relevantes. Obtener backlinks desde sitios confiables y relacionados con la industria refuerza la autoridad y credibilidad del dominio. No se trata de cantidad, sino de calidad y relevancia. Una estrategia de link building bien ejecutada puede marcar una diferencia significativa en el posicionamiento orgánico.

5 – Corroborar y optimizar la velocidad de carga del sitio

La velocidad de carga es un factor clave tanto para la experiencia del usuario como para el SEO. Sitios lentos tienden a tener mayores tasas de rebote y un peor rendimiento en los rankings. Optimizar recursos, mejorar el hosting, reducir scripts innecesarios y cumplir con los Core Web Vitals contribuye a una mejor experiencia y a un mayor potencial de posicionamiento.

¿Tu sitio web sigue sin posicionar en Google?

Si después de aplicar estas recomendaciones tu sitio web continúa sin lograr visibilidad en los resultados de búsqueda, es probable que existan factores técnicos, estratégicos o de autoridad que requieran un análisis más profundo.

En TeamWeik ayudamos a empresas y marcas a diagnosticar, corregir y optimizar su presencia orgánica mediante estrategias SEO personalizadas, basadas en datos y alineadas a los objetivos del negocio. Si necesitas una auditoría SEO profesional o acompañamiento para mejorar el posicionamiento de tu sitio web, contáctanos y conversemos cómo potenciar tu crecimiento orgánico de forma sostenible. 🚀 Agendá una consultoría gratuita con nuestros profesionales.

Preguntas frecuentes

1. Hace unos meses vi que toda mi web se encontraba indexada y ahora ya no aparece, ¿qué pasó?

Este comportamiento suele estar asociado a cambios técnicos o estructurales realizados en el sitio web. Google evalúa de forma continua las URLs que tiene indexadas y puede decidir desindexarlas si detecta bloqueos en el archivo robots.txt, la incorporación de etiquetas meta robots con la directiva noindex, cambios incorrectos en las etiquetas canonical o errores de rastreo recurrentes. También pueden influir migraciones mal ejecutadas, caídas de servidor, pérdida de enlazado interno o una disminución en la calidad del contenido. Google Search Console es la herramienta clave para identificar la causa específica.

2. ¿Cuánto tiempo tarda Google en indexar un sitio web nuevo?

No existe un plazo exacto para la indexación de un sitio web nuevo. En algunos casos, Google puede indexar páginas en pocos días, mientras que en otros el proceso puede demorar varias semanas. El tiempo depende de factores como la autoridad del dominio, la correcta configuración técnica, el enlazado interno, la existencia de backlinks externos y la frecuencia de rastreo asignada por Google. Enviar un sitemap XML y solicitar la indexación desde Google Search Console puede ayudar a acelerar el proceso, aunque no lo garantiza.

3. ¿Puedo forzar a Google a que indexe mi sitio web?

No es posible forzar la indexación de una página o sitio web. Google decide qué URLs indexar en función de su calidad, relevancia y accesibilidad. No obstante, se pueden mejorar las probabilidades asegurando que el sitio sea rastreable, eliminando bloqueos técnicos, optimizando el contenido y solicitando la indexación manual desde Google Search Console. Esta solicitud actúa como una señal para Google, pero no implica una indexación automática o inmediata.

4. ¿Es negativo que algunas páginas de mi sitio no estén indexadas?

No necesariamente. Es normal y, en muchos casos, recomendable que ciertas páginas no estén indexadas, como resultados internos de búsqueda, páginas de filtrado, landings temporales o contenidos de bajo valor. El objetivo no debe ser indexar todas las URLs, sino aquellas que aporten valor real a los usuarios y sean relevantes para la estrategia SEO. Una indexación controlada contribuye a una mejor calidad del índice y a un mejor rendimiento orgánico.

5. ¿Qué herramienta debo usar para detectar problemas de indexación?

Google Search Console es la herramienta principal para analizar el estado de indexación de un sitio web. A través de los informes de “Páginas” y la herramienta de inspección de URLs, es posible identificar errores de rastreo, exclusiones, bloqueos por robots.txt, etiquetas noindex y otros problemas técnicos. Complementar este análisis con herramientas de crawling como Screaming Frog permite obtener una visión más completa de la situación.